python爬蟲之bs4數(shù)據(jù)解析

因?yàn)檎齽t表達(dá)式本身有難度,所以在這里為大家介紹一下 bs4 實(shí)現(xiàn)數(shù)據(jù)解析。除此之外還有 xpath 解析。因?yàn)?xpath 不僅可以在 python 中使用,所以 bs4 和 正則解析一樣,僅僅是簡(jiǎn)單地寫兩個(gè)案例(爬取可翻頁的圖片,以及爬取三國演義)。以后的重點(diǎn)會(huì)在 xpath 上。

二、安裝庫閑話少說,我們先來安裝 bs4 相關(guān)的外來庫。比較簡(jiǎn)單。

1.首先打開 cmd 命令面板,依次安裝bs4 和 lxml。

2. 命令分別是 pip install bs4 和 pip install lxml 。

3. 安裝完成后我們可以試著調(diào)用他們,看看會(huì)不會(huì)報(bào)錯(cuò)。

因?yàn)楸救怂接邢蓿匀绻霈F(xiàn)報(bào)錯(cuò),兄弟們還是百度一下好啦。(總不至于 cmd 命令打錯(cuò)了吧 ~~)

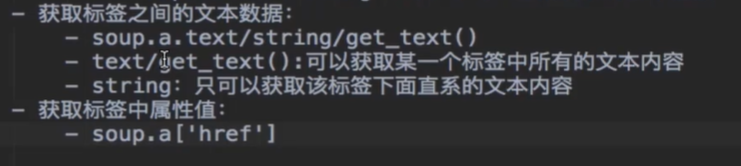

三、bs4 的用法閑話少說,先簡(jiǎn)單介紹一下 bs4 的用法。

import requestsfrom bs4 import BeautifulSoupimport osif __name__ == '__main__': # 創(chuàng)建文件夾 if not os.path.exists('./糗圖(bs4)'):os.mkdir('./糗圖(bs4)') # UA偽裝 header = {'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.72 Safari/537.36'} # 指定 url for i in range(1, 3): # 翻兩頁url = 'https://www.qiushibaike.com/imgrank/page/%s/' % str(i)# 獲取源碼數(shù)據(jù)page = requests.get(url = url, headers = header).text# 數(shù)據(jù)解析soup = BeautifulSoup(page, 'lxml')data_list = soup.select('.thumb > a')for data in data_list: url = data.img['src'] title = url.split('/')[-1] new_url = 'https:' + url photo = requests.get(url = new_url, headers = header).content # 存儲(chǔ) with open('./糗圖(bs4)/' + title, 'wb') as fp:fp.write(photo) print(title, '下載完成!!!') print('over!!!')五、爬取三國演義

import requestsfrom bs4 import BeautifulSoupif __name__ == '__main__': # UA 偽裝 header = {'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.90 Safari/537.36'} # URL url = 'http://sanguo.5000yan.com/' # 請(qǐng)求命令 page_text = requests.get(url = url, headers = header) page_text.encoding = 'utf-8' page_text = page_text.text soup = BeautifulSoup(page_text, 'lxml')# bs4 解析 li_list = soup.select('.sidamingzhu-list-mulu > ul > li')for li in li_list:print(li)new_url = li.a['href']title = li.a.text# 新的請(qǐng)求命令response = requests.get(url = new_url, headers = header)response.encoding = 'utf-8'new_page_text = response.textnew_soup = BeautifulSoup(new_page_text, 'lxml')page = new_soup.find('div', class_ = 'grap').textwith open('./三國演義.txt', 'a', encoding = 'utf-8') as fp: fp.write('n' + title + ':' + 'n' + 'n' + page)print(title + '下載完成!!!')

到此這篇關(guān)于python爬蟲之bs4數(shù)據(jù)解析的文章就介紹到這了,更多相關(guān)python bs4數(shù)據(jù)解析內(nèi)容請(qǐng)搜索好吧啦網(wǎng)以前的文章或繼續(xù)瀏覽下面的相關(guān)文章希望大家以后多多支持好吧啦網(wǎng)!

相關(guān)文章:

1. XML入門的常見問題(三)2. HTTP協(xié)議常用的請(qǐng)求頭和響應(yīng)頭響應(yīng)詳解說明(學(xué)習(xí))3. ASP將數(shù)字轉(zhuǎn)中文數(shù)字(大寫金額)的函數(shù)4. jscript與vbscript 操作XML元素屬性的代碼5. .NET Framework各版本(.NET2.0 3.0 3.5 4.0)區(qū)別6. XML在語音合成中的應(yīng)用7. 不要在HTML中濫用div8. php使用正則驗(yàn)證密碼字段的復(fù)雜強(qiáng)度原理詳細(xì)講解 原創(chuàng)9. ASP基礎(chǔ)入門第四篇(腳本變量、函數(shù)、過程和條件語句)10. HTML5實(shí)戰(zhàn)與剖析之觸摸事件(touchstart、touchmove和touchend)

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備